Umetna inteligenca Googla se uči analizirati svet skozi kamero pametnega telefona

Na MWC v Barceloni je Google predstavil revolucionarne nove funkcije za svoj AI asistent, Gemini. Od marca bodo imetniki naročnine na Google One AI Premium načrt lahko spremenili svoje pametne telefone v AI-podprte 'oči' zahvaljujoč dvema ključnima novostma—Live Video Analysis in Smart Screenshare.

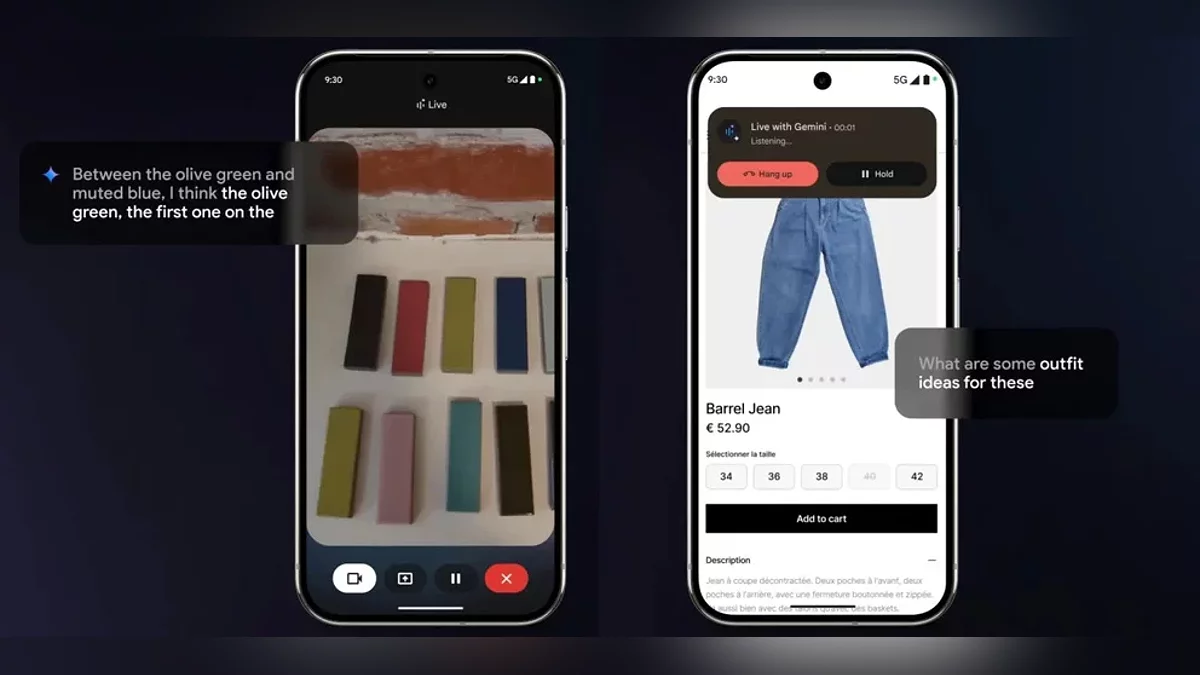

Live Video Analysis omogoča asistentu, da takoj obdeluje vhodne podatke iz kamere v realnem času. Uporabniki lahko usmerijo svojo kamero na kos oblačila za nasvete o stiliranju ali skenirajo prostor, da prejmejo predloge za notranjo opremo. Gemini ne "vidi" le tistega, kar je na zaslonu—aktivno sodeluje v dialogu. Na primer, uporabniki ga lahko vprašajo, naj optimizira navigacijsko pot ali pojasni zapleten grafikon v predstavitvi, pri čemer prejmejo razlage v dinamičnem, pogovornem formatu.

Za zdaj so te funkcije na voljo le na napravah Android z večjezično podporo. Na Google stojnici je podjetje prikazalo Gemini, ki deluje na napravah Samsung, Xiaomi in drugih partnerskih napravah, pri čemer je poudarilo medznamensko združljivost. Še ni podatkov, kdaj bodo uporabniki iOS dobili dostop.

Objavljene posodobitve so le en korak proti Googlovemu ambicioznemu projektu Astra. Do leta 2025 podjetje načrtuje razvoj univerzalnega multimodalnega asistenta, ki bo sposoben:

- Hkrati analizirati video, avdio in besedilne podatke;

- Ohranjati kontekst pogovora do 10 minut;

- Integrirati podatke iz Iskanja, Lens in Zemljevidov za celovite rešitve.

Čeprav Google uradno ni napovedal Astra kot samostojnega produkta, strokovnjaki špekulirajo, da bodo njegove funkcije postopoma vključene v Gemini, kar bo povečalo konkurenco s ChatGPT. Omeniti velja, da je OpenAI od decembra 2023 ponudil razširjen način glasovnega nadzora z analizo zaslona, vendar Google stavi na globoko integracijo s svojim ekosistemom.

Zmožnost AI, da obdeluje vizualne informacije v realnem času, zamegljuje mejo med digitalnim in fizičnim svetom. Uporabniki se ne ukvarjajo več le z "govorljivim asistentom", temveč sodelujejo z aktivnim udeležencem v svojih vsakodnevnih nalogah—od nakupovanja do učenja. Z lansiranjem Gemini Vision AI asistenti vstopajo v dobo hiper-kontekstualne interakcije, kjer se ključno vprašanje premakne z "Kako naj vprašam?" na "Kaj naj pokažem?"

Ostaja eno pomembno vprašanje: zasebnost. Kako bo Google zaščitil podatke, ki se prenašajo prek kamere in zaslona? Podjetje zagotavlja, da se vse analize izvajajo pod strogimi varnostnimi standardi, vendar bodo popolni podatki razkriti šele, ko bodo funkcije uradno objavljene.

-

Google je izdal prvo javno beta različico Androida 16

-

Google Chrome prehaja na samodejno upravljanje: brskalnik zdaj samodejno nadomešča ogrožene gesla

-

Google Play Protect zdaj zaznava grožnje v realnem času z velikim varnostnim nadgradnjo

-

Google je začel «Tiho vojno» proti blokatorjem oglasov: Priljubljena orodja za blokiranje oglasov propadajo

-

Izboljšana zaščita 2.0: Google Chrome uvaja obrambo, podprto z umetno inteligenco, proti neznanim grožnjam